El software que puede escribir pasajes de texto o hacer dibujos que parecen creados por un humano ha iniciado una fiebre del oro en la industria de la tecnología.

Empresas como Microsoft y Google luchan por integrar la IA de vanguardia en sus motores de búsqueda, mientras competidores multimillonarios como OpenAI y Stable Diffusion se adelantan y lanzan su software al público.

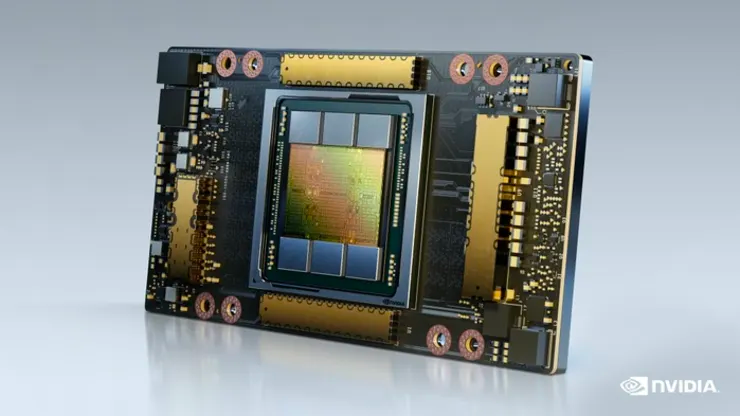

Muchas de estas aplicaciones están impulsadas por un chip de aproximadamente $ 10,000 que se ha convertido en una de las herramientas más críticas en la industria de la inteligencia artificial: el Nvidia A100.

El A100 se ha convertido en el «caballo de batalla» para los profesionales de la inteligencia artificial en este momento, dijo Nathan Benaich, un inversionista que publica un boletín informativo y un informe que cubre la industria de la IA, incluida una lista parcial de supercomputadoras que usan A100. Nvidia se lleva el 95% del mercado de procesadores gráficos que se pueden usar para el aprendizaje automático, según New Street Research.

El A100 es ideal para el tipo de modelos de aprendizaje automático que impulsan herramientas como ChatGPT, Bing AI o Stable Diffusion. Puede realizar muchos cálculos simples simultáneamente, lo cual es importante para entrenar y usar modelos de redes neuronales.

La tecnología detrás del A100 se usó inicialmente para generar gráficos 3D sofisticados en juegos. A menudo se le llama procesador de gráficos o GPU, pero en estos días, el A100 de Nvidia está configurado y dirigido a tareas de aprendizaje automático y se ejecuta en centros de datos, no dentro de brillantes PC para juegos.

Las grandes empresas o las nuevas empresas que trabajan en software como chatbots y generadores de imágenes requieren cientos o miles de chips de Nvidia y los compran por su cuenta o aseguran el acceso a las computadoras de un proveedor de la nube.

Se requieren cientos de GPU para entrenar modelos de inteligencia artificial, como modelos de lenguaje grandes. Los chips deben ser lo suficientemente potentes como para procesar terabytes de datos rápidamente para reconocer patrones. Después de eso, también se necesitan GPU como la A100 para la «inferencia» o el uso del modelo para generar texto, hacer predicciones o identificar objetos dentro de las fotos.

Esto significa que las empresas de IA necesitan acceso a muchos A100. Algunos empresarios en el espacio incluso ven la cantidad de A100 a los que tienen acceso como una señal de progreso.

“Hace un año teníamos 32 A100”, escribió en enero el director ejecutivo de Stability AI, Emad Mostaque, en Twitter. “Sueñen en grande y apilen más GPUs para niños. Brrr.” Stability AI es la compañía que ayudó a desarrollar Stable Diffusion, un generador de imágenes que llamó la atención el otoño pasado y, según se informa, tiene una valoración de más de mil millones de dólares.

Ahora, Stability AI tiene acceso a más de 5400 GPU A100, según una estimación del informe State of AI, que traza y rastrea qué empresas y universidades tienen la mayor colección de GPU A100, aunque no incluye proveedores de nube, que no No publicar sus números públicamente.

Nvidia está montando la A.I. tren

Nvidia se beneficiará del ciclo de exageración de la IA. Durante el informe de ganancias del cuarto trimestre fiscal del miércoles, aunque las ventas generales disminuyeron un 21 %, los inversionistas impulsaron las acciones un 14 % el jueves, principalmente porque el negocio de chips de IA de la compañía, informado como centros de datos, aumentó un 11 % a más de $ 3.6 mil millones en ventas durante el trimestre, mostrando un crecimiento continuo.

Las acciones de Nvidia han subido un 65 % en lo que va de 2023, superando por igual al S&P 500 y a otras acciones de semiconductores.

El CEO de Nvidia, Jensen Huang, no podía dejar de hablar sobre IA en una llamada con analistas el miércoles, sugiriendo que el reciente auge de la inteligencia artificial está en el centro de la estrategia de la compañía.

“La actividad en torno a la infraestructura de IA que construimos, y la actividad en torno a la inferencia usando Hopper y Ampere para influir en los grandes modelos de lenguaje se ha disparado en los últimos 60 días”, dijo Huang. “No hay duda de que cualquiera que sea nuestra opinión sobre este año, al entrar en el año, ha cambiado bastante dramáticamente como resultado de los últimos 60 o 90 días”.

Ampere es el nombre en clave de Nvidia para la generación de chips A100. Hopper es el nombre en clave de la nueva generación, incluido el H100, que recientemente comenzó a distribuirse.